用ChatGPT作弊,小心被抓,防抄袭水印技术,让学生的噩梦提前到来

日期:2023-01-27 14:21:03 / 人气:412

利用ChatGPT等AI模型作弊引起广泛关注,水印正成为解决这一问题的“利剑”。

最近,对话式AI模型ChatGPT风头正劲。有人用ChatGPT写代码,修复bug;还有人用ChatGPT写神经网络,结果非常好用,不用改一个字。但ChatGPT在学校作业、论文发表等领域引起了广泛关注,并采取了相应措施。

1月初,纽约教育官员宣布禁止学生在公立学校使用ChatGPT的消息引发争议。人们对ChatGPT的担忧已经蔓延到了AI学术界本身,全球知名的机器学习会议之一ICML最近宣布,禁止发表包含ChatGPT和其他类似系统生成的内容的论文,以避免“意想不到的后果”。

针对这些反馈,ChatGPT的发起者OpenAI正在努力开发缓解措施,帮助人们检测AI自动生成的文本。OpenAI首席执行官山姆·奥特曼(Sam Altman)提出尝试水印技术和其他技术来标记ChatGPT生成的内容,但表示不可能做到完美。

大规模语言模型的潜在危害可以通过对模型的输出进行水印处理来缓解,即在生成的文本中嵌入信号。这些信号人类是看不到的,但算法可以从短程token中检测出来。

本文中,来自马里兰大学的几位研究人员对ChatGPT等语言模型输出的水印进行了深入的研究。他们提出了一个高效的水印框架,其中水印嵌入对文本质量的影响可以忽略不计,高效的开源算法可以用于检测,不需要访问API或者语言模型的参数。此外,这种方法可以检测相对较短的合成文本(少至25个标记),同时使人类文本在统计上不可能被标记为机器生成的。

地址:https://arxiv.org/pdf/2301.10226v1.pdf.

本文提出的水印具有以下特性:

它可以在不知道模型参数,不访问语言模型API的情况下通过算法检测,所以即使模型不开源,检测算法也可以开源。同时,LLM无需加载或运行,检测成本低,速度快;

您可以使用标准语言模型来生成带水印的文本,而无需重新训练。

仅从生成文本的连续部分检测水印,因此当使用生成部分创建较大的文档时,仍然可以检测到水印;

如果生成的令牌有很大一部分没有被修改,水印就不能被删除;

计算检测到的水印的严格统计置信度。

马里兰大学副教授、论文作者之一汤姆·戈尔茨坦(Tom Goldstein)表示:“OpenAI正计划阻止ChatGPT用户的一些作弊行为。同时可以通过水印输出来辨别内容是否由ChatGPT生成。在一个参数为1.3B的模型中,一个新的语言模型水印框架只用23个单词就检测到了LLM生成的文本,我们有99.994%的置信度检测到它。」

毫不夸张地说,这篇论文标志着LLM抄袭和反抄袭checker之间竞争的开始。

这种方法的出现也让网友们为学生捏了一把汗,大呼“加油,高中生!」

在方法介绍部分,首先,本研究介绍了一种简单的水印方法(硬黑名单水印),易于分析、检测和删除。这种方法通过生成禁止令牌的黑名单来工作。在水印检测中,需要访问语言模型来生成水印文本,但不需要检测水印。了解哈希函数和随机数生成器的第三方可以为每个令牌重新生成黑名单,并计算违反黑名单规则的次数。

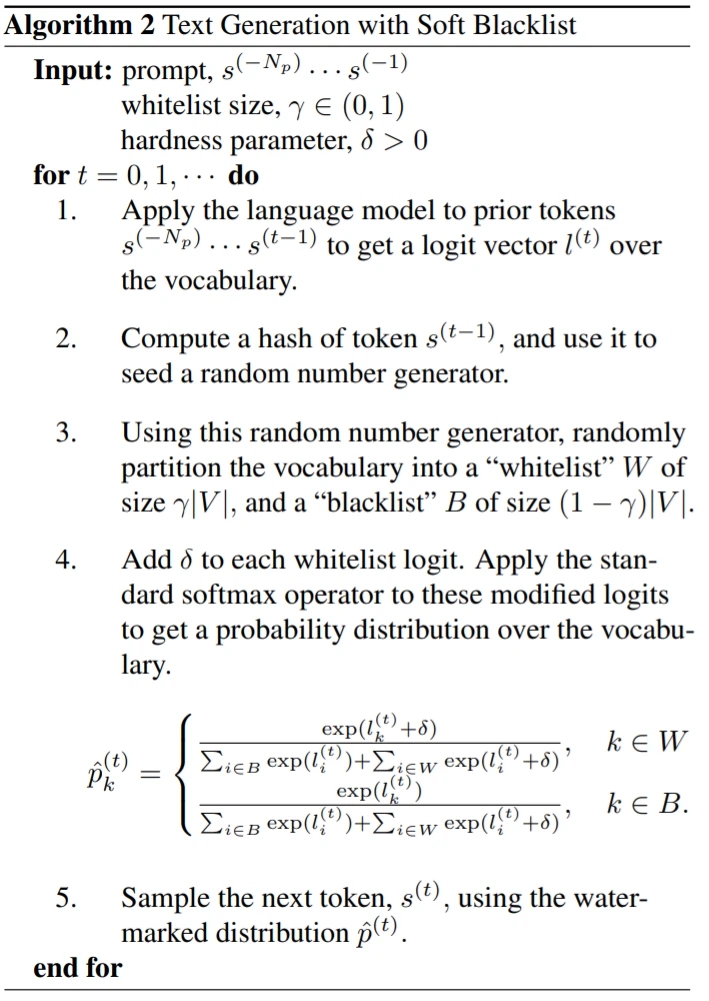

此外,本研究还使用了一种称为软水印的检测方法。这个算法并没有严格禁止黑名单令牌,而是在白名单令牌的对数上加了一个常数δ。算法如下:

上述水印算法被设计成公开的。事实上,该算法也可以在私有模式下运行,使用一个随机密钥,该密钥是保密的,并托管在API上。如果攻击者不知道用于生成黑名单的密钥,攻击者很难删除水印,因为攻击者不知道哪些令牌被列入黑名单。

研究人员表示,水印检测算法可以公开,让第三方(如社交媒体平台)自行运行,也可以保持私有,在API后面运行。

实验

实验使用OPT-1.3B模型探索水印效果。为了模拟各种语言建模场景,本研究从C4数据集中随机选取文本进行切片。

图2(左)示出了各种水印参数组合的水印强度(Z得分)和文本质量(混淆)之间的权衡。

表2提供了各种水印参数的差错率表。此外,在图4的ROC图中扫描了一系列阈值。

作者:长安娱乐

新闻资讯 News

- 宝格丽的地图事件发酵,冲上热搜...07-13

- 遮住衣柜门后,热巴出现在机场,...07-13

- 让球鞋的评测在八年内成为真正的...07-13

- 费玉清病危,昏迷不醒?姐妹朋友...07-13